Un incident massif a frappé le Web ce lundi 20 octobre 2025. De nombreuses plateformes grand public et professionnelles sont tombées en cascade, touchant l’Europe et l’Amérique du Nord. L’épicentre se situerait chez un hyperscaler, rappelant notre dépendance critique aux clouds et à quelques régions très sollicitées.

A retenir :

- Panne d’ampleur internationale liée à un fournisseur cloud majeur.

- Services grand public et outils pros indisponibles pendant des heures.

- Dépendance systémique révélée : monitoring, redondance et “runbooks” en question.

Panne mondiale du 20 octobre 2025 : l’essentiel à connaître

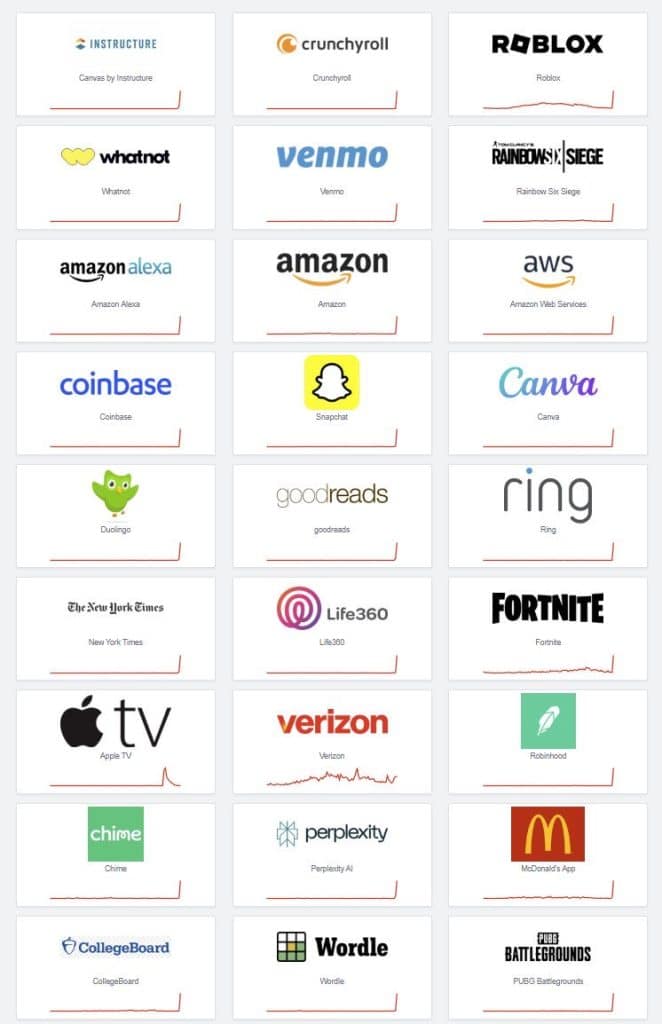

Les premières alertes sont apparues peu avant 9 h (heure de Paris). Elles se sont propagées à une longue liste de services. Des sources concordantes ont signalé des taux d’erreurs accrus et des latences sur plusieurs briques critiques, avec un impact mondial. Selon The Verge, des produits comme Alexa, Fortnite, Snapchat, Airtable ou encore Canva ont connu des dysfonctionnements notables.

L’étendue de l’incident a été rapidement corroborée par des tableaux de bord de signalements et des confirmations d’éditeurs. Selon Business Insider, plus de trente services cloud ont été affectés côté fournisseur, tandis que des plateformes tierces comme Signal, Zoom, Strava ou Perplexity ont reconnu des indisponibilités liées à leur hébergeur.

Du côté européen, l’onde de choc a aussi été visible. Selon le Financial Times, des services bancaires et télécoms ont été perturbés, avec une cause opérationnelle en cours d’analyse au moment des faits.

« Ce type d’événement rappelle que la résilience ne se résume pas à un SLA marketing : elle exige des architectures multi-régions testées, des procédures d’escalade et une communication transparente avec les utilisateurs. »

Les principaux défis mis à nu par la panne du 20 octobre

La panne a agi comme un stress test à grande échelle. Quatre fragilités émergent clairement.

Dépendance concentrée aux régions les plus utilisées

Beaucoup d’entreprises européennes ancrent encore leurs charges critiques sur quelques régions historiques, souvent pour des raisons de coûts ou d’habitudes. Quand l’une d’elles “tousse”, l’écosystème tousse. Selon The Verge, la concentration des charges sur des régions phares amplifie chaque incident.

Monoculture d’infrastructures

Le risque systémique tient à la concentration : un même fournisseur héberge une part immense des back-ends modernes. Quand il flanche, les chaînes de valeur complètes—authentification, paiements, analytics, contenus—se figent. Selon Business Insider, la dépendance en cascade a touché des briques partagées par des milliers d’applications.

Observabilité et “runbooks” perfectibles

Beaucoup d’équipes ont détecté l’incident via les plaintes utilisateurs avant leurs dashboards. Cela signale souvent une télémétrie trop locale (app-centric) et une surveillance insuffisante des fournisseurs (cloud-centric). Selon le Financial Times, les pages “statut” et la communication technique ont parfois manqué de granularité.

Communication temps réel avec les usagers

Plusieurs marques ont tardé à contextualiser l’incident. Résultat : pics de tickets, hausse des désinstallations et perte de confiance évitables avec une page statut et des messages in-app clairs, factuels, horodatés.

Impacts et conséquences : utilisateurs, marques, secteur

Pour le grand public

L’accès à Snapchat, Roblox, Fortnite, Prime Video, Duolingo, Canva ou des services musicaux a fluctué. Les utilisateurs ont subi des déconnexions, des échecs de paiement, des temps de chargement très longs, et parfois des fonctionnalités bridées.

Pour les entreprises

- Ventes et onboarding bloqués par des APIs indisponibles.

- SAV saturés, NPS en berne, coût relationnel en hausse.

- Chaînes CI/CD et ETL interrompus, retards de livraison.

- KPI en biais à cause d’analytics et de webhooks en panne.

Pour les marchés et la régulation

L’épisode survient dans un contexte d’incidents rapprochés. Les régulateurs pourraient renforcer les exigences de réversibilité et de souveraineté opérationnelle, notamment pour les secteurs régulés et les services d’importance vitale.

Solutions et initiatives : que faire dès aujourd’hui ?

1) Diversifier : multi-régions, multi-AZ… et parfois multi-cloud

Répliquez les données transactionnelles et les secrets sur au moins deux régions réellement indépendantes, active-active si possible. Testez le basculement chaque trimestre. Investissez dans une stratégie DNS prête pour le failover.

2) Séparer le plan de contrôle du plan de données

Une panne de contrôle (auth, routage, IAM) peut neutraliser un cluster sain. Isoler le minimum vital (auth de secours, service catalogue, artefacts) sur un autre fournisseur ou on-prem. Documentez RTO/RPO et modes dégradés.

3) Durcir l’observabilité fournisseur

Ajoutez des probes synthétiques vers vos dépendances critiques (statuts cloud, endpoints IAM, DNS managés) et déclenchez des alertes quand les latences s’emballent.

Dans vos runbooks, prévoyez des scénarios “cloud indispo” avec bandeaux utilisateurs standardisés.

4) Parlez tôt, parlez clair

Publiez un message factuel en moins de 15 minutes : portée, cause présumée, prochain point d’étape. Un bandeau in-app réduit les tickets et préserve la confiance. Rédigez des templates à l’avance et localisez-les.

5) Gouvernance et contrats

Négociez RTO/RPO réalistes, accès prioritaire au support, rétro-plan de crise cosigné. Documentez la réversibilité (export des données, re-déploiement, cartographie des dépendances).

Une petite checklist utile, concentrée et actionnable

- Cartographier les dépendances externes.

- Établir SLI/SLO côté services tiers.

- Simuler désactivation régionale.

- Automatiser basculement DNS.

- Pré-rédiger templates de crise.

Chronologie et services touchés : la panne en un coup d’œil

| Heure (Paris) | Faits saillants | Services/secteurs cités | Indices observables |

|---|---|---|---|

| ~08:40–09:10 | Premiers pics de signalements en Europe | Snapchat, Roblox, Fortnite, Prime Video, Canva | Montée rapide des échecs de connexion et latences |

| Matinée | Confirmation de pannes et de latences multi-services | Région cloud très sollicitée | Messages d’incidents et erreurs applicatives |

| Fin de matinée | Propagation perçue grand public et pro | Apps, banques, télécoms | Pages statut et communications éditeurs |

“Nous avions une redondance intra-région, pas inter-régions. Quand la région phare a vacillé, notre plan B n’a servi à rien. Le plus dur n’a pas été technique, mais la gestion des clients en direct.”

Deux retours d’expérience actionnables

Architecture e-commerce paneuropéenne

Contexte : un acteur retail dépend d’authentification centralisée sur une seule région.

Problème : panne régionale → login impossible → chiffre d’affaires à zéro durant deux heures.

Remédiation : cache des claims JWT côté edge + fallback d’auth sur région indépendante + grace period sessions.

Résultat : lors d’un test ultérieur, 90 % des parcours sont restés opérationnels en mode dégradé.

SaaS B2B de productivité

Contexte : pipelines ETL et webhooks adossés à des queues managées.

Problème : saturation et timeouts en chaîne.

Remédiation : queues auto-hébergées pour le critique + retry backoff exponentiel + journaux d’audit client accessibles offline.

Résultat : aucune perte de message, rattrapage en moins d’une heure lors d’un exercice de chaos engineering.

La souveraineté opérationnelle devient un thème central pour les DSI européens. L’incident relance le débat : comment équilibrer performance, coûts et capacité à encaisser une panne majeure ? Les organisations doivent documenter la continuité d’activité et tester réellement leurs bascules.

Recommandations pratiques pour les équipes métiers et tech

- Segmenter les parcours : lecture seule possible si l’écriture échoue.

- Prioriser les fonctionnalités “vitales” et afficher un mode maintenance pour le reste.

- Documenter une communication client en trois temps (alerte, point d’étape, post-mortem).

- Entraîner les équipes : exercice table-top trimestriel, drill “DNS failover”.

Sources

- Selon The Verge, l’épicentre probable touche une région cloud très utilisée et de grands services grand public.

- Selon Business Insider, plusieurs dizaines d’outils du fournisseur ont été listés comme impactés, avec des éditeurs tiers dépendants.

- Selon le Financial Times, la piste d’un « problème opérationnel » a été évoquée, avec des équipes mobilisées pour la mitigation.

Vous avez vécu l’incident dans votre entreprise ? Partagez votre avis en commentaire et dites-nous ce qui a tenu… ou cédé.